Error de aproximación

La incertidumbre o error numérico es una medida del ajuste o cálculo de una magnitud con respecto al valor real o teórico que dicha magnitud tiene. Un aspecto importante de los errores de aproximación es su estabilidad numérica. Dicha estabilidad se refiere a cómo dentro de un algoritmo de análisis numérico el error de aproximación es propagado dentro del propio algoritmo.

El concepto de error es consustancial con el cálculo numérico. En todos los problemas es fundamental hacer un seguimiento de los errores cometidos a fin de poder estimar el grado de aproximación de la solución que se obtiene.

Tipos de errores

editarLos errores asociados a todo cálculo numérico tienen su origen en dos grandes factores:

Inherentes a la formulación del problema

editar

El error absoluto por definición siempre es positivo, ya que se toma el valor absoluto de la diferencia entre el valor real y el valor aproximado.

Pero la diferencia entre el valor real y el aproximado o medido ( que se suele llamar error real), puede ser positivo si el error es por defecto, o negativo si el error es por exceso.

Si el error absoluto < ε, se dice que ε es una cota de error absoluto. Entonces la ε relativa es:

Una fuente de este tipo de errores tiene su origen en la imprecisión de los datos físicos: constantes físicas y datos empíricos. Es el caso de errores en la medida de los datos empíricos y tienen un carácter generalmente aleatorio, su tratamiento analítico es imprescindible para contrastar el resultado obtenido computacionalmente.

Consecuencia del método empleado para encontrar la solución del problema

editarEn lo que se refiere al segundo tipo de error (error computacional), tres son sus fuentes principales:

1. Equivocaciones en la realización de las operaciones (errores de bulto). Esta fuente de error es bien conocida por cualquiera que haya realizado cálculos manualmente o empleando una calculadora. El empleo de computadores ha reducido enormemente la probabilidad de que este tipo de errores se produzcan. Sin embargo, no es despreciable la probabilidad de que el programador cometa uno de estos errores (calculando correctamente el resultado erróneo). Más aún, la presencia de bugs no detectados en el compilador o en el software del sistema no es inusual. Cuando no resulta posible verificar que la solución calculada es razonablemente correcta, la probabilidad de que se haya cometido un error de bulto no puede ser ignorada. Sin embargo, no es esta la fuente de error que más nos va a preocupar.

2. El error causado por resolver el problema no como se ha formulado, sino mediante algún tipo de aproximación. Generalmente está causado por la sustitución de un infinito (sumatorio o integración) o un infinitesimal (diferenciación) por una aproximación finita. Algunos ejemplos son:

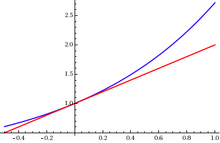

- El cálculo de una función elemental (por ejemplo, seno x) empleando sólo n términos de los infinitos que constituyen la expansión en serie de Taylor.

- Aproximación de la integral de una función por una suma finita de los valores de la función, como la empleada en la regla del trapecio.

- Resolución de una ecuación diferencial reemplazando las derivadas por una aproximación (diferencias finitas).

- Solución de la ecuación f(x) = 0 por el método de Newton-Raphson: proceso iterativo que, en general, converge sólo cuando el número de iteraciones tiende a infinito.

Denominaremos a este error, en todas sus formas, como error por truncamiento, ya que resulta de truncar un proceso infinito para obtener un proceso finito. Obviamente, estamos interesados en estimar, o al menos acotar, este error en cualquier procedimiento numérico.

3. Por último, la otra fuente de error de importancia es aquella que tiene su origen en el hecho de que los cálculos aritméticos no pueden realizarse con precisión ilimitada. Muchos números requieren infinitos decimales para ser representados correctamente, sin embargo, para operar con ellos es necesario redondearlos. Incluso en el caso en que un número pueda representarse exactamente, algunas operaciones aritméticas pueden dar lugar a la aparición de errores (las divisiones pueden producir números que deben ser redondeados y las multiplicaciones dar lugar a más dígitos de los que se pueden almacenar). El error que se introduce al redondear un número se denomina error de redondeo.

Experimentos físicos y errores de aproximación

editarLas medidas de las diferentes magnitudes físicas que intervienen en una experiencia dada, ya se hayan obtenido de forma directa o a través de su relación mediante una fórmula con otras magnitudes directamente, nunca pueden ser exactas. Debido a la precisión limitada que todo instrumento de medida posee, así como de otros factores externos, se debe aceptar el hecho de que no es posible conocer el valor exacto de una magnitud, siempre habrá un error, por muy mínimo que sea. Por lo tanto, cualquier resultado numérico obtenido experimentalmente debe presentarse siempre acompañado de un número que indique cuanto puede alejarse dicho resultado al valor exacto. Esto es un margen o rango de error.